Diventa free member

Vuoi leggere questo articolo e le altre notizie e approfondimenti su Ninja? Allora registrati e diventa un membro free. Riceverai Breaking News, Marketing Insight, Podcast, Tips&Tricks e tanto altro. Che aspetti? Tieniti aggiornato con Ninja.

Diventa free member

Vuoi leggere questo articolo, le altre notizie e approfondimenti su Ninja? Allora lascia semplicemente nome e mail e diventa un membro free. Riceverai Breaking News, Marketing Insight, Podcast, Tips&Tricks e tanto altro. Che aspetti? Tieniti aggiornato con Ninja.

Internet, e i Social in particolare, favoriscono la diffusione di informazioni e conoscenza. Uno strumento prezioso quindi sia per la democrazia che per il progresso.

Ma gli stessi meccanismi che permettono la propagazione, a volte virale, delle informazioni valide, amplificano e diffondono quelle meno valide che si propagano come un incendio boschivo devastante.

E qui occorre, secondo alcuni studiosi, un distinguo: perché se è facile definire l'informazione come "Notizia, dato o elemento che consente di avere conoscenza più o meno esatta di fatti, situazioni, modi di essere" (Treccani), la disinformazione può prendere diverse forme e sfumature.

La disinformazione può essere mirata a illudere e frodare (e in inglese la definiscono misinformation) oppure prodotta intenzionalmente per fuorviare (disinformation). La propaganda è invece un cocktail di informazione e disinformazione (nelle due accezioni) spesso costruito e diffuso per scopi politici.

Sull'arte della disinformazione è nata una vera e propria scienza, l'agnotologia (non cercate su Wikipedia, non c'è nella versione italiana).

Il dott. Proctor, della Stanford University, usò per primo questo neologismo nel suo libro "The Cancer Wars: How Politics Shapes What We Know and Don't Know About Cancer" pubblicato nel 1995.

Robert Proctor, storico della scienza, prendeva come esempio di informazione deliberatamente manipolata quella diffusa dagli industriali del tabacco, impegnati fin dal 1969 a sminuire gli effetti nocivi delle sigarette.

Fate bene attenzione, che l'agnotologia non è lo studio dell'ignoranza in sé, ma della sua deliberata produzione: "il dubbio è il nostro prodotto" scrissero nel loro memo segreto (fu rivelato nel 1979) gli industriali del tabacco.

Charles Simic, in un articolo pubblicato nel 2012 su "The New York review of books" definiva la nostra l'Era dell'Ignoranza (Age of Ignorance), un era in cui internet e la tv hanno favorito la diffusione della disinformazione ad una scala prima impensabile, ma non ritiene (e giustamente!) che sia lo strumento da incolpare. Afferma anzi che per il sistema politico ed economico sia poco conveniente avere una popolazione veramente informata, istruita e consapevole delle proprie scelte.

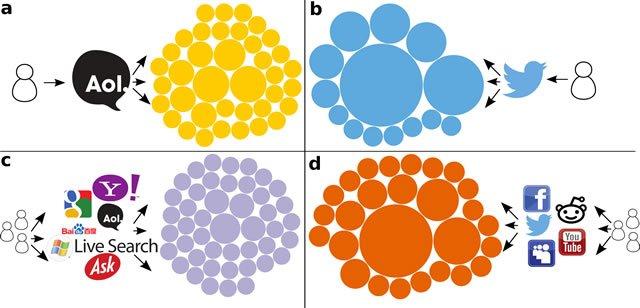

Internet e i Social network non sono dunque la causa della stupidità e l'ignoranza, come sostengono in tanti, ma ne favoriscono la propagazione rapida e di massa, sia perché ogni utente è, potenzialmente, un produttore di contenuti (un editore) sia perché, dati gli altissimi numeri in gioco, è molto difficile verificare le fonti o l’attendibilità di una notizia.

Immagine da Twitter

Alla biennale democrazia, lo scorso marzo, ne hanno parlato pure il direttore del Post Luca Sofri e Filippo Menczer, professore di Informatica e computer science all’Università dell’Indiana, Stati Uniti, coordinati dal giornalista Luca De Biase. Proprio De Biase afferma: "Circola molto un pensiero per cui è Internet il responsabile della nostra disinformazione. Non è vero, ciò che rende confusa la discussione è che veniamo da un sistema di pensiero per cui esistevano il bar e i giornali. Il primo è il posto delle fuffe, i secondi quello da prendere sul serio. Internet è entrambe le cose".

Una ricerca su Google sarebbe sempre utile e opportuna, ma ha ragione anche Luca Sofri, che in quella occasione afferma: "Quando leggiamo qualcosa su un giornale quotato siamo subito più convinti, neanche immaginiamo di dover fare un controllo dei fatti".

Ma se anche ci si lanciasse a verificare una notizia, il successo non è assicurato e così il problema si riduce di poco. Il rumore di fondo è a volte tanto elevato che nemmeno i più esperti o i professionisti riescono a verificare facilmente una notizia.

Così, per esempio, alla notizia della morte di David Bowie, ADNKronos reagisce pubblicando una nota in cui viene data per una bufala e l'Unione Sarda la riprende pubblicandola a sua volta.

Infatti Google, ma anche Facebook e Twitter, cercano dei modi per limitare la propagazione di bufale e per favorire l’affioramento delle notizie più attendibili.

Google e Twitter hanno un approccio basato sugli algoritmi, Facebook si appoggia anche al feedback dei suoi utenti. I metodi usati includono il machine learning e l'elaborazione del linguaggio naturale (Natural language processing) ma non si limitano a queste sole tecniche.

Filippo Menczer studia da anni i meccanismi di diffusione delle bufale o meme come vengono definiti dal suo team e oltre a un gran numero di articoli e studi, ha creato un sito in cui mette a disposizione alcuni strumenti molto interessanti.

Visitando il sito del suo progetto Truthy, potrete, per esempio, verificare se un certo handle twitter sia più probabilmente un BOT o un essere umano, o scaricare i dati usati per le loro ricerche e i video. Prossimamente, annunciano, sarà rilasciato uno strumento per visualizzare la diffusione dei meme che vi interessano.

Un recentissimo studio (dicembre 2015) condotto da alcuni ricercatori italiani ha cercato di stabilire i meccanismi siano gli stessi, per le bufale, di quelli delle informazioni scientifiche.

Lo studio del team composto da ricercatori del IMT Alti Studi Lucca, della università Sapienza di Roma e dello IUSS istituto per studi avanzati di Pavia e della università di Boston si è concentrato sugli utenti di Facebook e di come questi si comportino nei confronti di due tipi di notizie: notizie scientifiche e notizie relative a teorie cospiratorie.

Tenendo conto di precedenti ricerche, la disintermediazione dell’informazione resa possibile dal web ha cambiato la maniera in cui gli utenti si informano, causando un incremento della confusione, delle speculazioni e voci.

La continua esposizione degli utenti a bufale, voci e pettegolezzi provocherebbe un aumento della loro credulità: l’aggregazione in gruppi omogenei che condividono un sistema di credenze fanno si che gli utenti si costruiscano un proprio quadro di riferimento (framing), spesso distorto dalla ricerca di auto-conferme, un meccanismo mentale ben noto.

Già negli anni ’90 ne L’illusione di sapere, Massimo Piattelli Palmarini fece una rassegna degli errori più comuni in cui si può cadere, inconsapevolmente, nel prendere decisioni o valutare le informazioni disponibili applicando studi di psicologia cognitiva ai processi decisionali.

La diffusione della disinformazione è favorita (anche) dalle bolle di informazione a cui gli utenti attingono

Secondo il meccanismo del framing (lo si può tradurre come incorniciamento, ma anche fregatura) l’inquadramento di una informazione ricevuta in termini positivi o negativi determina nelle persone un tipo di risposta diverso.

Questo rende possibile pilotare le scelte di costoro presentando la stessa informazione in un modo piuttosto che in un altro.

Non pensiate di essere immuni a questo tipo di bias cognitivo: tutti ne siamo più meno vittime.

Ne volete un esempio simpatico? senza sbirciare in qualche cartina geografica, rispondete al volo a questa domanda: dovendo volare da Napoli verso Trieste, che direzione prendereste? Nord? Nord - est? O nord - ovest? Dopo che avrete risposto, controllate pure, e vi stupirete.

La propagazione della disinformazione, dichiarano gli studiosi, ha dimensioni tali che il world economic forum la classifica come uno dei maggiori rischi da affrontare, per l’umanità, già dal 2012. Nel 2015 il rischio, incluso nella voce "cyber attacks" è ancora maggiore.

Non si può liquidare, da snob, questo fenomeno pensando sia dovuto esclusivamente alla stupidità delle persone: sono molti i meccanismi, secondo questo studio, che concorrono ad esso. Il principale è la tendenza delle persone di scegliere e diffondere notizie prese da amici o persone di cui si fidano, perché spesso fanno parte di un gruppo (una camera dell’eco, la chiamano) che condivide lo stesso profilo di polarizzazione.

La diffusione della disinformazione verrebbe quindi favorita dalla creazione di comunità di interessi in cui la disinformazione viene amplificata e rinforzata oltre che dal sistema di valori e credenze condiviso anche dalla sfiducia (in altre fonti) e dalla paranoia.

I fattori per cui ciò accade sono:

Le notizie scientifiche verrebbero diffuse più rapidamente e per un tempo maggiore, ma senza che a questo corrisponda un aumento del interesse per la notizia stessa, mentre le voci relative a cospirazioni e complotti sarebbero assimilate più lentamente ma la loro vita (l’interesse) è più lunga, derivando in una maggiore diffusione.

Un approccio puramente algoritmico come quello di Google, Facebook o Twitter non sembra, agli studiosi, possibile nè ottimale: gli algoritmi potrebbero essere poco accurati o inefficaci e limitare la libera circolazione dei contenuti in generale.

Questa limitazione non mette rischio solo l’informazione autorevole, ma potrebbe anche essere usata dai complottisti a conferma delle loro tesi, presentandola come un tentativo (ulteriore) di disinformazione e censura ai loro danni.